Microsoftは2025年2月25日、デジタル環境と物理環境の両方で情報を処理し、アクション提案を生成するように設計されたマルチモーダルAI基盤モデル「Magma」を発表した。

Magmaは、入力されたテキストと画像に基づいてテキストを生成できるだけでなく、UIナビゲーションやロボット操作、一般的な画像とビデオの理解、空間の理解と推論など、さまざまなマルチモーダルタスクを実行させることがきるAIモデル。視覚言語行動(VLA)モデルと呼ばれるもので、通常は多数のVLAデータセットで事前トレーニングされ、空間を認識して対話する能力を獲得し、幅広いタスクを実行できるが、デジタル環境と物理環境の大幅な違いのため、用途に合わせて別々のVLAモデルがトレーニングされ、異なる環境に対して使用される。このため、これらのモデルのほとんどは一般化できておらず、汎用的に利用するのは難しかった。

Magmaでは新たにSet-of-Mark(SoM)、およびTrace-of-Mark(ToM)という2つの技術革新によって、この問題を解決している。SoMはアクションのための「注意が必要な点」を事前にマークすることで、ロボット操作などのアクションの起点に関するヒントを提供する。またToMは、オブジェクトの動きを時間経過に沿ってトレースする線を組み込むことで、動的な変化についてのヒントをMagmaに与えている。

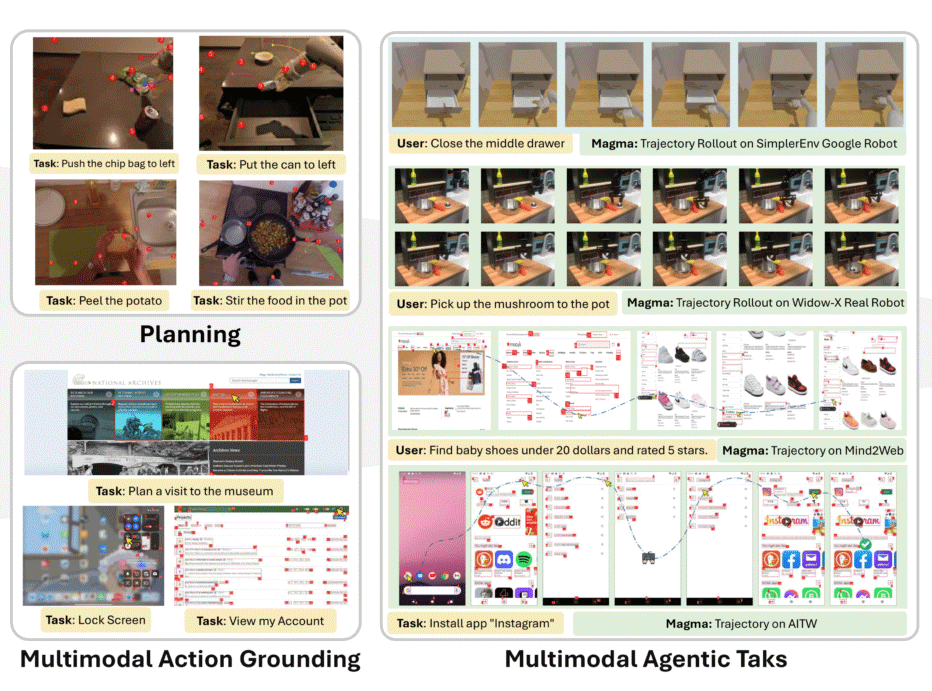

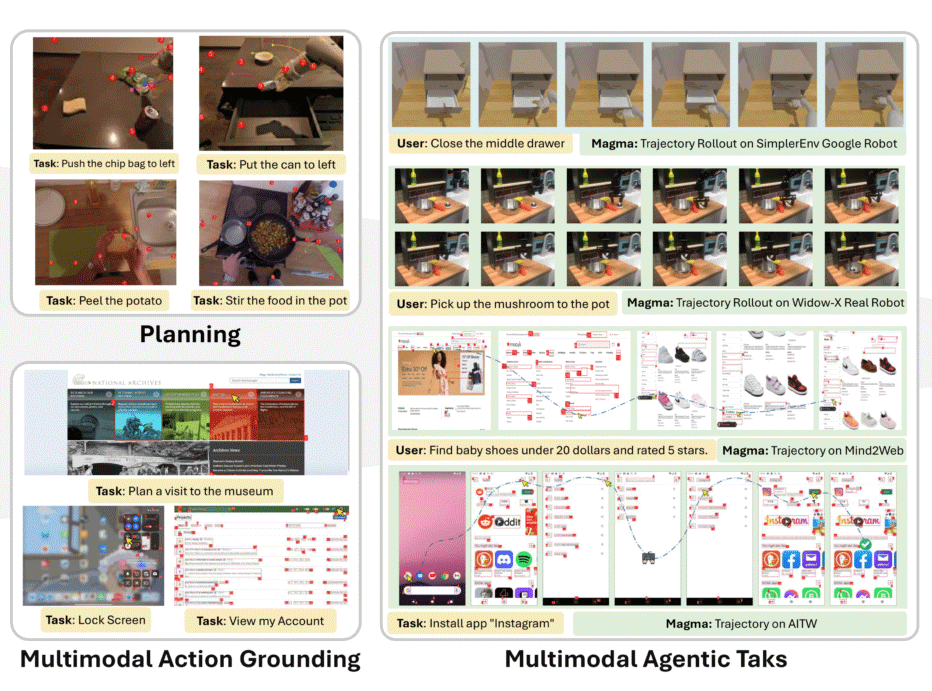

Magmaによる操作の例。赤い点はSoMによりマークされているポイント。こうしたポイントをToMにより動きの線としてマークし組み合わせることで、ロボットに料理をさせたり、「中段の引き出しを開ける」といったプロンプトでロボットを操作することができる。

MagmaはMITライセンスのもと、Azure AI Foundry LabsとHuggingFace上で公開されている。