あけましておめでとうございます。本年も宜しくお願いいたします。

2009年までを振り返ってみても、ネットブックの登場で一般のユーザが意識せずクラウドサービスを使ったり、iPhoneやWindows 7でマルチタッチに触れたり、私達の生活はこの数年、新しい技術やデバイスのコモディティ化によって劇的に変化しています。2010年の新年にふさわしい何か未来っぽい話をということで、今回はマイクロプロジェクターを中心に、2010年以降のデバイス&コンピューティングについて想像していきたいと思います。

2009年はマイクロプロジェクター元年

昨年はポケットサイズのマイクロプロジェクターが市場に出回った記念すべき年でした。それまで大型液晶ディスプレイの薄型軽量化に押されぎみだったプロジェクターに一筋の光が差したと言っても言い過ぎ?ではないかもしれません。

2008年の年末に3MのMPro110、OptomaのPicoProjectorが次々と発売され、その後ニコンからプロジェクター内蔵のデジタルカメラCOOLPIX S1000pjまで登場しました。

次の「プロジェクターがPCに進化する時」は私がマイクロプロジェクターの存在を知ったちょうど一年数ヵ月前に「マイクロプロジェクタで時代が変わる!」と思いブログに描いた2009年の未来予想です。昨年を振り返りながら読んでいただければと思います。

Optoma Pico Projector

プロジェクターがPCに進化する時

プロジェクターにWebカメラを内蔵させ、映し出してるモノに触って操作できたら便利なのに……。そういう発想からプロジェクターがPCに進化する日は近いはずです。ノートPCやモバイルフォンの大きさを規定しているのは画面やキーボードといった物理デバイスの大きさだから、入力と出力の部分を机や壁に任せてしまえば未来のPCの姿が見えてくると思いませんか?

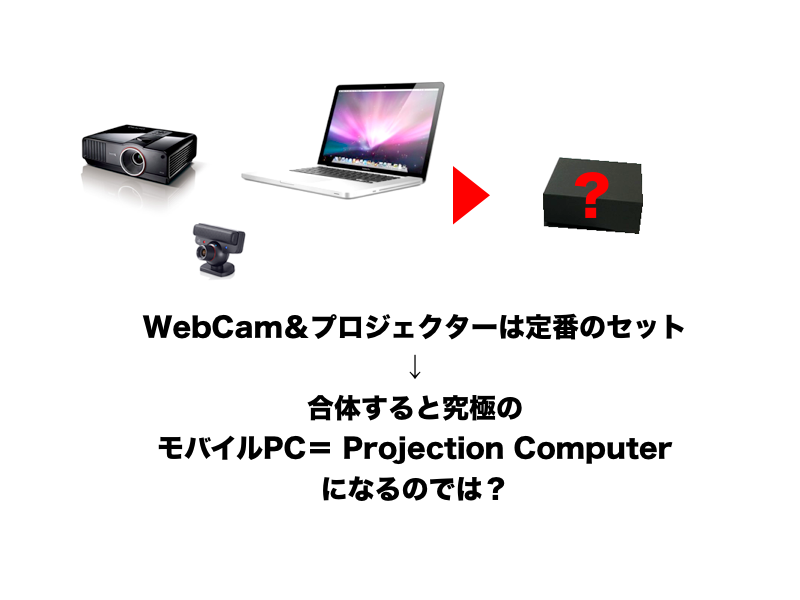

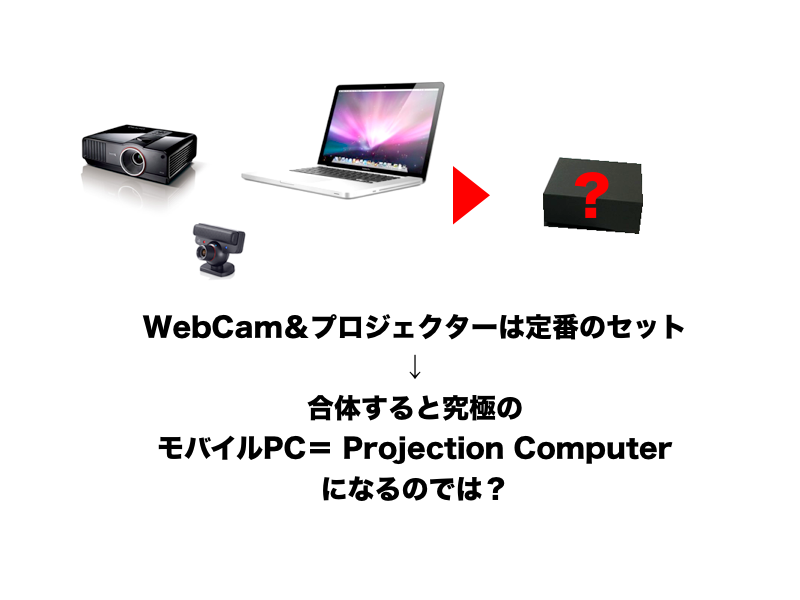

WebCam&プロジェクターの合体

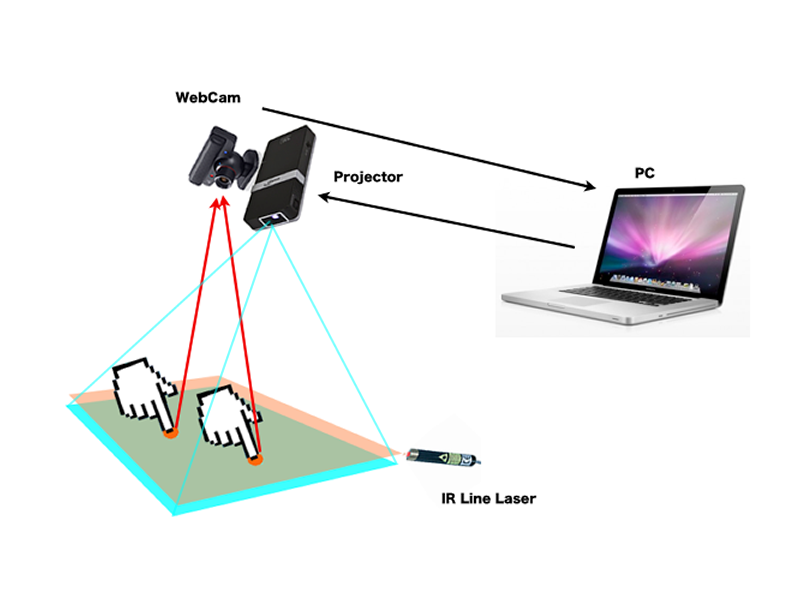

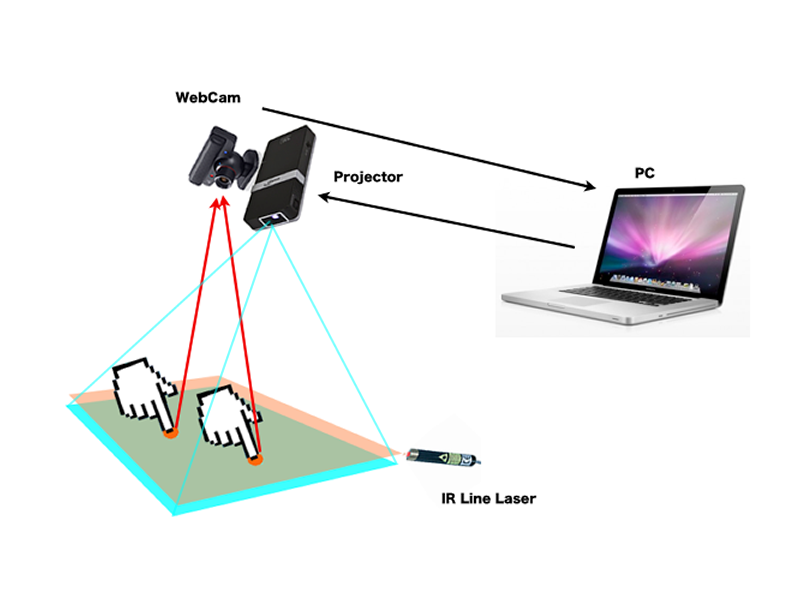

まずは、光学系を共通化してプロジェクターとWebカメラを1つの箱に入れます。Webカメラをセンサーにすれば投影された画面を操作できるし単純に組み合わせる以上のシナジーはあると思います。赤外線レーザーなどの補助光を使えば今でも簡単に実現可能ですし、投影画像とカメラ画像の差分を比較すれば触れている場所の計算は難しくありません。ビジネス用途にレーザーポインタや手で投影している画面をダイレクトに操作できる需要は十分にあるはずです。

ノートPCとプロジェクタを持ち運ぶのなら「プロジェクタをPCにすれば?」という発想は当然出てきます。Wi-fi、Bluetoothがあれば何もいらない。デザイン的にはツルテカの立方体のモノリスのような感じでしょうか。1つの頂点だけ斜めにカットしたデザインのようなタバコ2つ分ぐらいの「黒い箱」をテーブルに置くと、テーブルにキーボードと画面が投影されて、触って操作できるのは会議にも便利だと思います。

プロジェクション・コンピュータのイメージ

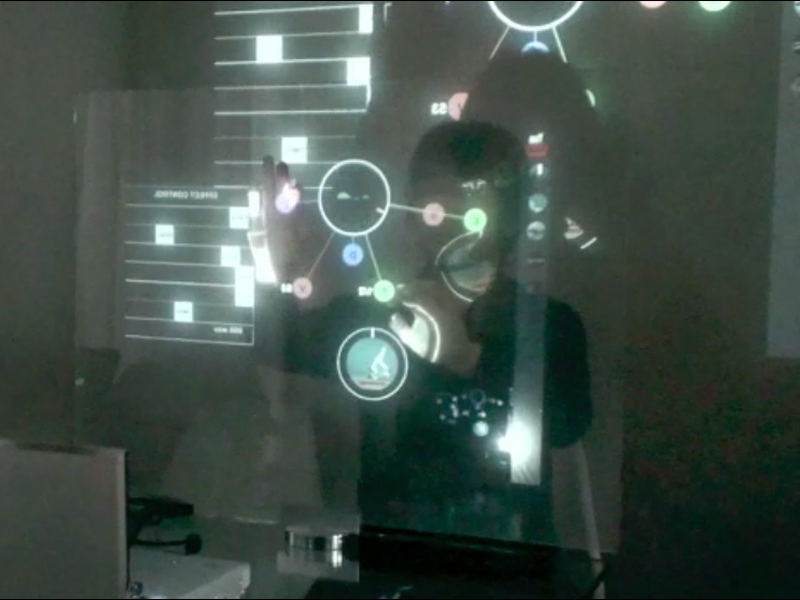

今度は90度回転させて壁やホワイトボードの手前に置いて遠くからはレーザーポインタで、近くなら壁に直接触れて操作します。技術的にもプロジェクタの進化は早く、すでにiPod大のDLP方式のプロジェクタやレーザープロジェクタが実用化されているのでパームトップも可能なはずです。一番の問題は光学系ですが、画質ではなくて利便性をとりハードウェアで無理をせず歪みはソフトウェアで強制的に補正(マッピング)するのが良いと思います。未来では空間に3Dで投影して超音波で手ごたえを感じたりするのかもしれません。ツルピカの黒箱を手のひらにのせてプレゼンでこう言ったりしてみたいですね。

「PCを再発明する!」

2010年はプロジェクション・コンピューティングが来る!

プロジェクション・コンピューティングとは?聞きなれない言葉ですが、それもそのはず私が提唱中のバズワード(Buzzword)です。プロジェクションを辞書でひくと【projection/出っ張り、突起、投影】とあります。何となく最近流行りのフィジカル・コンピューティングとも相性が良さそうです。私なりにプロジェクションコンピューティングを定義してみました。

■プロジェクション・コンピューティング

立体物または平面に、プロジェクタとカメラを組み合わせた機器で情報を投影し、投影されたオブジェクトを通じてPCを操作出来るしくみ。

いかがでしょうか? 家や街中の照明がカメラ付きプロジェクターに置き換わり、その明かりの下では壁や机がドコデモタッチパネルに、持っているモノがナンデモコントローラになってしまうような未来。PCやネットを意識せず身の回りにある情報にアクセスできるしくみがプロジェクション・コンピューティングであると私は考えます。

プロジェクション・コンピューターのプロトタイプ製作

机上の空論では説得力がありませんので、実際にプロジェクションコンピューターのプロトタイプとして「電気スタンド型コンピュータ」を試作してみました。

電気スタンド型コンピュータのイメージ

試作した電気スタンド型コンピュータ

試作した電気スタンド型コンピュータ

理想的には先程述べたような、タバコの箱大に収めて文鎮のようにテーブルの上に置いて使ったり、電球型にして照明と置き換えて使うのが理想なのですが、小型なものを自作するのは難しいため発想を転換しテーブルを照らすお馴染みの電気スタンドの形状にしました。本当ならシェードがあって、ポチンとツマミを回すと電源がONになりテーブルにプロジェクションされるような、電気スタンド本来のアフォーダンスになっていれば最高なのですが、プロトタイプなのでアームの先端にWebCamとPicoProjectorを付けただけの簡素な物になっています。コンピュータが電気スタンド型になっていれば、お爺さんお婆さん、どんな人にも使えて素敵だとおもいませんか?

動作原理は単純です。指先を照らすための補助光として、赤外線ラインレーザーをテーブルの上に置いて使用するのですが、指で机にタッチをすると指先に赤外線レーザーが当たり、光った部分を赤外線改造されたWebCamで撮影しマルチタッチの座標を取得します。

電気スタンド型コンピュータの動作原理

制作費はアーム、プロジェクター、レーザー、WebCamでだいたい3万円ぐらい。最も安価なマルチタッチ環境の出来上がりです。実際に使用してみると、なかなか快適で、焦点距離や操作面積を考えると電気スタンドのカタチが今のところ一番の最適解なのではと思います。不要なときは机の脇に寄せておけるというのも便利です。木の机やザラザラした壁などの本来タッチパネルで無い素材に触れて操作するのも不思議な感覚で可能性を感じます。

プロジェクション・コンピュータのデモ動画

Projection Computing Demo with touche from nucode on Vimeo.

WebCamとプロジェクタを身につけるMITの“SixthSense”

出てくるだろうなと思ってはいたのですが、昨年MITから発表された帽子にマイクロプロジェクター(3M MPro110)とWebCamを仕込んで指にカラーマーカー(ビニールテープ?)を巻いてウェアラブルコンピューティングを実現した第六感コンピューティングです。スゴイです。余談ですが、セカイカメラの井口さんと話をしたときに、プロジェクション・コンピューティングじゃ名前がイケてない、“SixthSense”のほうが良いネーミングだと言われたのは秘密です。

プロジェクションはARを進化させるのか?

プロジェクションと相性の良い技術にAR(Augmented Reality)があります。ARは拡張現実とも呼ばれ、WebCamやケータイのカメラで撮影されているリアルな世界の中に、マーカーを置くことで、あたかもそこに存在するかのように3DのCGオブジェクトをリアルタイムに合成する技術です。最近ではFlashを使ったWebや、iPhoneのアプリでもよく目にするようになってきました。

実際に試してみるとマジックをみているような面白さがあるのですが「画面の中だけでしか体験できない」のでかなり残念です。ARを一度体験すると「これが裸眼で見ることができればスゴイのに」という欲求は当然出てくると思います。ARはいつまで画面をノゾキコムのでしょうか?技術的にも不可視マーカーとプロジェクターの組み合わせで裸眼でARを見せることは可能です。

一番の問題点は裸眼の場合、顔を動かすと表示オブジェクトの画角がズレてしまう事です。その答えとして「WebCamで顔(目)の位置を検出すれば今の技術で裸眼ARは十分に作ることは可能…」と昨年10月のAR関連のセミナーでお話をさせて頂いたのですが、つい昨年の12月にAppleが同様な顔の位置を認識して画面内のオブジェクトをリアルな3Dに見せる特許を取得したというニュースを読んで驚きました。

個人的には今年こそプロジェクターを使って画面を覗き込まずにフィジカルコンピューティングとARを組み合わせた体験がしてみたい…と期待しています。

好きな石ころがコントローラに!

プロジェクターのメリットとして、リアルなモノや環境との相性がディスプレイに比べて遥かに良いことが挙げられます。何の変哲も無い、川原で拾ってきた丸い石が、プロジェクターの光源に照らされた瞬間にUIが周りに表示され、コントローラになるという未来はもうすぐそこです。カメラでの認識はレスポンスの点でまだまだ課題もありますが、デバイスが内包するハードの形状などの制約から開放されることでデザインもまた、シンプルミニマルな現在のトレンドからよりユーザーが使っていて心地良い形状、新しいカタチ、アートや工芸に近づいていくのではないかと私は考えています。

タンジブルやフィジカルコンピューティングが注目されていますが、前述のARも含め今後プロジェクションと組み合わせたバリエーションが今年は数多く出てくると思います。

レーザー版マイクロプロジェクターの登場で加速するプロジェクション・コンピューティング

これまで述べてきました、プロジェクション・コンピューティング、プロジェクションを使ったAR、石ころをコントローラに、という話も今年からは決して大げさな夢物語ではないかもしれません。

フィジカルコンピューティングとプロジェクションの連携が2010年以降に加速すると考えられる理由のひとつにレーザーを光源にしたマイクロプロジェクターの登場が挙げられます。発売を目前に控えているのMicrovisionのレーザープロジェクターShowwxや、日本信号?のMEMSデバイスであるエコスキャンなど、今年は小型のレーザープロジェクターを応用した製品が続々と登場するでしょう。従来のプロジェクターで懸念された・光源の熱・ファンの騒音・設置場所の確保といった問題や、LEDマイクロプロジェクターの・輝度が足りない・ピント合わせが面倒といった課題はレーザープロジェクターではほぼ解決されておりピント合わせが不要というレーザーならではの特徴が、積極的な立体物への情報投影や環境設備への埋め込みにつながるのではないかと期待しています。

また、センシングの観点からもレーザーとカメラを使ったセンサーは、安価な非接触の入力デバイスとして優れているので、表示用のレーザーと共に組み込まれる可能性は大いにあります。また、デジタルサイネージにおいても従来のディスプレイとは違った場所でのユーザー体験を演出できるので、レーザープロジェクターとカメラを使ったインタラクションは新しい表現の可能性を秘めています。

お正月、街に繰り出す時にはぜひ、ここに情報が投影されたら良いなあ…とか、この置物はコントローラになるかなあ・・とか考えながら過ごしてみてください。新しい発見があるかもしれません。

未来楽器プロジェクトとは

最後に私のライフワークである未来楽器プロジェクトについてお話をさせて頂ます。

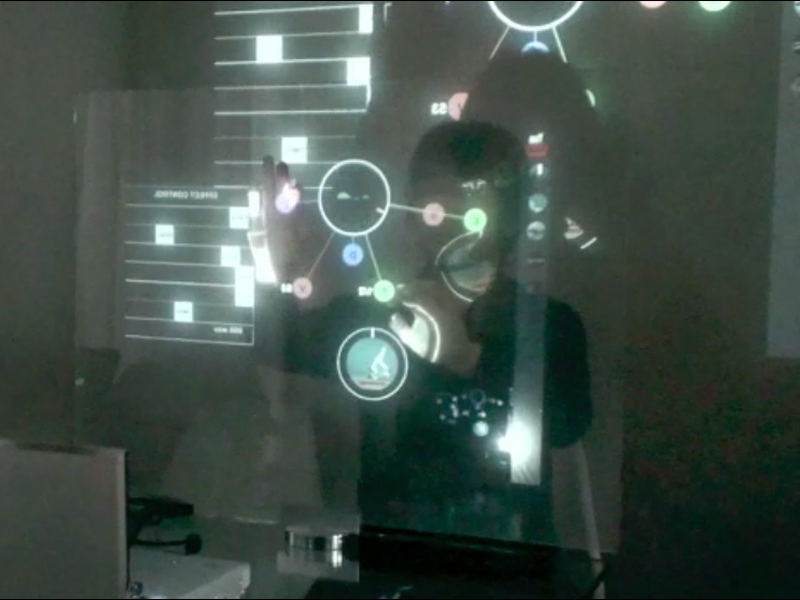

未来楽器パネルタイプテスト中

未来楽器テーブルトップ演奏中

未来楽器テーブルトップ演奏中

Projection Demo (Castalian) MiraiGakki from nucode on Vimeo.

未来楽器プロジェクトは2008年から始めた私の個人プロジェクトです。ゲーム業界にいたころから“音・映像・テキストなどの情報を演奏(プレイ)する”というのが私の核となるコンセプトでした。今考えると“ゲーム”というより“楽器”が作りたかったのだと思います。

未来楽器の基本アイデア自体は2000年ぐらいに考えていたことなので、おそらく当時の同僚が見れば「まだやっていたのか!」と驚くと思いますが、ようやく実現できる時代になったのかもしれません。実際にモノを見て頂くのが一番わかりやすいので、ぜひ動画で御覧下さい。キーワード「未来楽器」で検索です。

■未来楽器とは何か(定義)

AR、タッチスクリーンなどの「新しい技術」で「ネット上の映像・音・テキスト・・」を「モノのように操作=演奏」することができるデバイスやアプリを「未来楽器」と呼ぶ。

未来楽器自体は、その時代時代のテクノロジーに合わせカタチを変え進化していきます。2009年度の未来楽器は、自作のマルチタッチ環境(タッチパネルやプロジェクション)とActionScript3で書かれたアプリを使って、ネット上の音や動画を演奏するものです。

「もうね、重い機材もレコードも持たずに体一つでクラブに行ってプレイできるよね……。YouTubeやVimeoに素材あげておけばさ」

(あるDJとVJ、Twitterの会話より)

未来楽器=情報を演奏する

従来の楽器が演奏する「音」を未来楽器ではすべての情報にまで拡大しリアルタイムに編集する行為を「演奏」と呼んでいます。構造を直感的に把握し、リアルタイムに再構成できる、「演奏できる楽譜」未来楽器ではそんな可能性を探っています。

テクノロジーの進歩が粘土をこねるような操作やリアルタイムな情報構造の再構成を可能にしてくれるでしょう。それが、動画・音・テキストを使ったライブ演奏の新しい形態なのかもしれません。