前回はUGC(User-Generated Content:一般ユーザーによって生成されるコンテンツ)と仮想空間サービス「Second Life」について取り上げた。今回はまったく新しい本のカタチについて書いてみたい。

本と映像の融合

書籍や雑誌がデジタル化されると紙媒体では不可能だった機能が実現する。本連載の第9回で紹介した「雑誌の検索読み」などは代表的な機能だといえる。記事の該当箇所を引用してみよう。

Zinio社のサイトにアクセスして右上のSEARCH欄に「Adobe CS3」と入力してみてほしい。Adobe CS3に関する情報が、どの雑誌の何ページに掲載されているか一覧される。そして、実際に掲載ページを見ることができるのだ(対象ページは画像で表示される) 。注目すべき点はこの「検索」機能である。ネットのコンテンツとしてはもはや当たり前の機能で、サービスとしての新規性はないが「紙媒体の雑誌+キーワード検索機能」として見れば、大きな進歩である。検索しながら読む行為、いわゆる「検索読み」が可能になる。これは紙媒体の雑誌を丸ごとデジタルした場合のメリットといえる。

本の「検索読み」 、そして(さまざまなシステムを横断して一括検索する)本の「横断検索」などが可能になりそうだが、はやくも次のステップとして「映像とのマッチング」が注目されている。これは、新しいデジタル本のカタチを形成する可能性がある。

現在のオンラインマガジンには、動画(ビデオやアニメーション)も取り込まれており、紙媒体では表現できない定番の手法となっている。ただし、コンテンツとして作り込まれている点では、インターネットが商用化される前からCD-ROMマガジン等で採用されていたものと大きな違いはない。「 映像とのマッチング」というのは、本の中の「文章」と映像の中の「シーン」が有機的に結びつくイメージにちかい。

概念的な話だけでは進まないので、現在おこなわれている「シーンの引用」を例にしていこう。動画共有サービスmotionbox の「Deep Tagging」が初歩としてわかりやすい。このサービスの売りは投稿したビデオのシーンに対してタグ付けができることだ。つまり、ビデオから言及したいシーンだけを引用できるのである(たとえば、30分のビデオの「問題シーン」10秒だけを簡単にブログなどに貼り付けることができる) 。

Deep Taggingの実践

それでは具体的なイメージを得るため、実際に「Deep Tagging」を実践してみよう。

まず、ビデオファイルをアップロードする。motionboxのアップローダーはFlashによるインターフェイス。デザインも洗練されており、使いやすい。ここでは、ビデオ全体に対してのタグ付けしかできない。

アップローダーでビデオをアップロードする

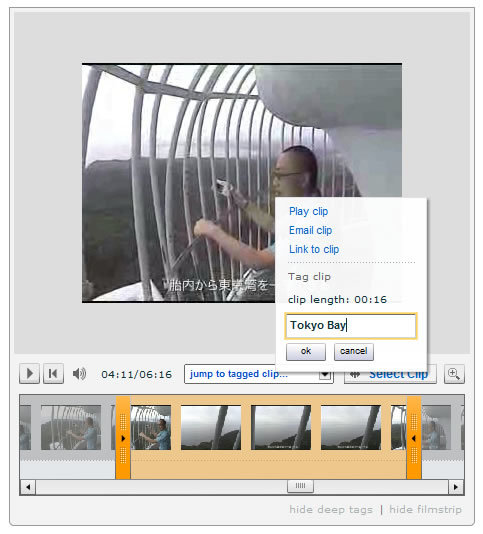

アップロードされたビデオの下部にはタイムラインが表示されている。カーソルでフレームをスクロールさせながらシーンを流し見することができる。たとえば、「 東京湾を一望する」シーンに対して「Tokyo Bay」というタグを付けたい場合、タイムラインをドラッグしてシーンを選択、表示されるポップアップメニューから[Tag clip]を選ぶ。入力欄にタグを入れて[OK]をクリックするという手順だ。

ビデオの「東京湾を一望するシーン」に「Tokyo Bay」というタグをつける

参考:東京湾を一望する」シーンのURL (クリックするとビデオの参照シーン16秒だけが再生される)

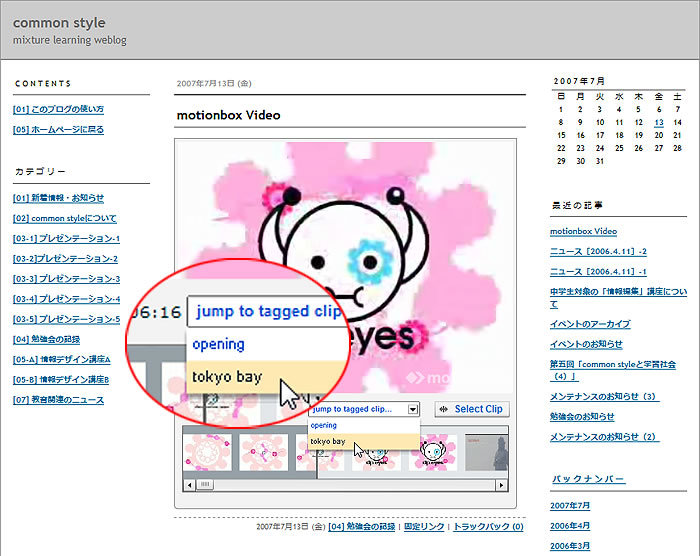

このビデオをブログに貼り付けてみる。再生画面の下にある[jump to tagged clip]メニューから「tokyo bay」を選ぶと東京湾を一望するシーンから再生が始まる。DVDのチャプターのような機能として捉えてほしい。

ブログに貼り付けたビデオは、チャプターのようにシーンを自由に選択できる

シーンを検索する

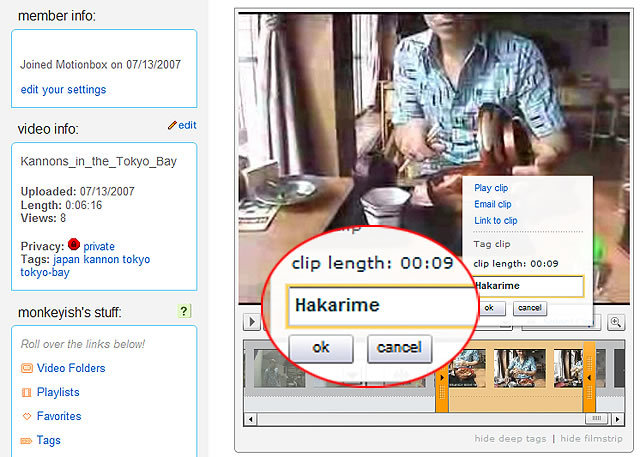

今度は、「 はかりめ料理を食べる」シーンに対して「Hakarime」というタグを付ける。料理を食べる9秒のシーンを選択した。

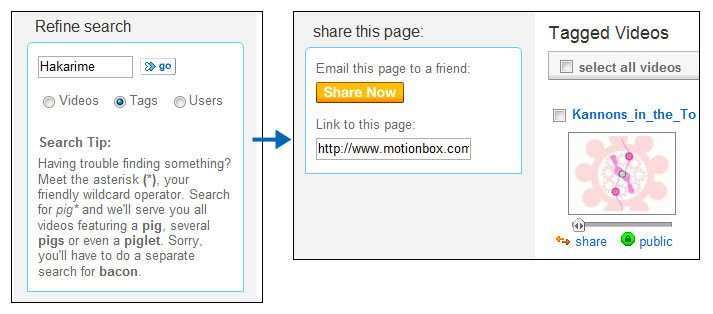

motionboxのサーチを使って検索する。[ Tag]をチェックして「Hakarime」と入力し、検索するとタグ付けされているビデオが表示された。このようにシステム内ではシーン検索も可能となる。

ビデオ内のシーンに付けられたタグで検索できる

ブログに貼り付けられたビデオを見ると、「 hakarime」のタグが追加されている。当然だが、シーンのタグが増えると、ブログに貼り付けられているビデオもすべてアップデートされる。

長時間のビデオでもシーンのタグが増えれば、より引用しやすくなる

シーンの引用とコメント

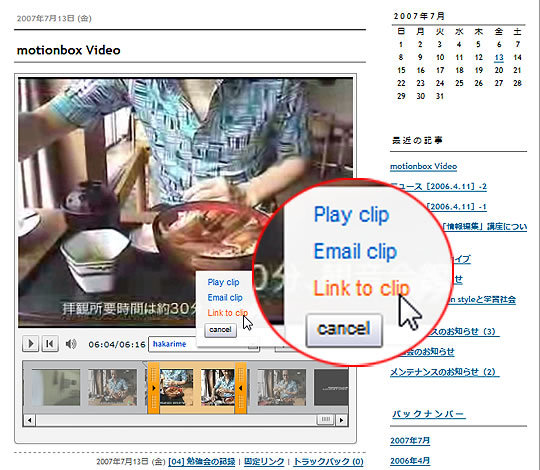

ユーザーがビデオ内のあるシーンに対して言及したい場合は、対象とするシーンを選択してメニューから[Link to clip]を選ぶ。

問題にしたいシーンを選択して引用する

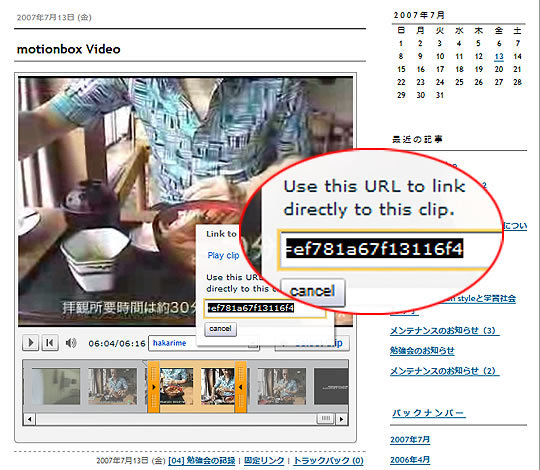

URLが書き出されるので、記事にペーストする。ビデオの投稿者にシーン引用付きでコメントしてもよいだろう。取得したURLは、引用のシーンだけ再生するので、まさにテキストのような手軽さで扱うことができる。

取得したURLは、選択したシーンだけ再生する

UGC系のまったく新しい本

motionboxの「Deep Tagging」は是非、体験してみてほしい。このようなシーンの引用が高度化し、もっと「手軽に」実践できるようになると、今まで実利的に困難だったコンテンツ作りが可能になる。

私が現在、進めているのが「教科書とビデオ教材の融合」である。重要なのは、私たちが「作り込まない」ことである。あくまで「場」を提供して、UGC(User-Generated Content)に委ねる。形式知の集積が利用者にとっても有益となる「場」をデザインすることが「UGC系の出版社(UGCパブリッシャー) 」の役割ということになる。仮想図書館のイメージもデジタルアーカイブだけではなく、映像メディアとのパッチワークのような融合を容易にする「Mixture Web 」へと広がりつつある。

次回は、CGM TVなどの動向にもふれながら「新しい本のカタチ~UGC Publishing」について追求していきたい。