あけましておめでとうございます。よういちろうです。今年もよろしくお願いいたします。

昨年の年始に「2018年のスマートスピーカー 」と題した記事を寄稿しましたが、日本において昨年はスマートスピーカーが多くの方々に利用され始めた記念すべき年となりました。テレビCMでもかなり流れていましたので、Google Home、Amazon Echo、そしてClova Waveといったスマートスピーカーをほとんどの人々が認識している状況になったと言えるでしょう。

本記事では、平成から元号が変わる記念すべき今年、AIアシスタントがどうなっていくのか、その見通しを紹介します。「 あれ、スマートスピーカーではなくAIアシスタント?」と思うことでしょう。まずはその話から始めてみましょう。

本記事では、日本においてプラットフォーム化をすでに遂げているGoogleアシスタント、Amazon Alexa、そしてLINE Clovaを対象とします。

スマートスピーカーからAIアシスタントに

声で様々な情報を検索したりIoT機器を操作することが可能な、一昨年に日本にて華々しくデビューし、昨年普及の速度が加速したデバイス、それは「スマートスピーカー」です。特に昨年の前半にはGoogle Home、Amazon Echo、そしてClova WaveやClova Friendsの販売競争が激しくなり、プロモーションのためのキャンペーンが数多く行われていました。良く目にした言葉、耳にした言葉は、これらスマートスピーカーの製品名だったかと思います。

しかし、昨年の後半に少し事情が変わってきていたことに気がついていたでしょうか? 特にグーグルについては、Google HomeのテレビCMよりも、「 それ、Googleにやらせよう。 」というテレビCMのほうが印象に残っているのではないでしょうか? Amazonについても、LINEについても、それぞれ「Alexa」や「Clova」という言葉がより印象に残るようなテレビCMであったと思います。

つまり、昨年は「スマートスピーカーの販売」から「Googleアシスタント、Alexa、Clova」といった「AIアシスタント」についてのブランディング確立に徐々に変化していた年だったのです。

声で操作する(Voice User Interface = VUIと呼ばれています)デバイスとして、スマートスピーカーは「画面を持たない」という特徴的なデバイスでした。つまり、VUIをユーザに体験してもらうためのデバイスとしては、スマートスピーカーは最適なデバイスと言えます。しかし、本当にユーザに利用してもらいたいサービスは、Googleアシスタント、Alexa、Clovaといった「AIアシスタント」です。

VUIでの操作の対象はAIアシスタントであって、スマートスピーカーはAIアシスタントにユーザがアクセスするための「数あるデバイスの中の一つ」に過ぎません。AIアシスタントのブランディングを考えていけば、スマートスピーカー自体のプロモーションが減っていくことは戦略上理にかなっていると言えるでしょう。

デバイスの多様化が加速する

さて、「 スマートスピーカー ≠ AIアシスタント」という構図になったということは、AIアシスタントを利用できるデバイスがスマートスピーカーだけではなくなった、ということです。多くの人々は、AIアシスタントを主に以下のデバイスから利用していたと考えられます。

Googleアシスタント

スマートスピーカー(Google Home, Home mini, その他)

スマートヘッドフォン、スマートイヤホン

スマートフォン(Android, iOS)

スマートウォッチ(Wear OS)

スマートテレビ(Android TV)

スマートディスプレイ(Google Home Hub, その他)

車載デバイス(Android Auto, その他)

Amazon Alexa

スマートスピーカー(Amazon Echo, Echo Dot, Echo Spot, Echo Plus, その他)

スマートヘッドフォン、スマートイヤホン

スマートフォン(Android, iOS)

Amazon Fire テレビ Stick 4K(テレビに挿すことでAlexaを利用可能)

スマートディスプレイ(Echo Show)

車載デバイス(Echo Auto, その他)

LINE Clova

スマートスピーカー(Clova WAVE, Friends, Friends mini)

スマートイヤホン

実際に昨年中に動作実績があるデバイスの種別だけでも、上記のように多彩です。また、発表されている対応予定のデバイスも今年は登場してくることでしょう。面白いデバイスとしては、スマートリングと言えるかもしれないGoogleアシスタントが利用できる指輪が発売されます。

指がスマートフォンの代わりになる ORII - Makuake

AIアシスタントを利用できるデバイスが増えれば増えるほど、そしてデバイスの種別が増えれば増えるほど、人々がAIアシスタントを利用する頻度は増えることになり、AIアシスタントから恩恵を受けられる可能性が上がります。AIアシスタントはユーザにとって「相棒」のような常に隣にいて助けてくれる存在になることが目指すべき姿だとすると、デバイスの多様性が進むほどにその状況に近づいていくわけです。

昨年はやっとスマートスピーカー以外のデバイスが出始めた年でしたが、今年はAIアシスタント対応のデバイスの種類がもっと増えます。その結果として、ユーザがAIアシスタントに触れることが可能なタッチポイントも増えます。そして、今まで「スマートスピーカー」というデバイスに興味を持っていた人々も、今年はデバイスにではなくその先にある「AIアシスタント」に興味の軸が移行していくのではないか、と考えられます。

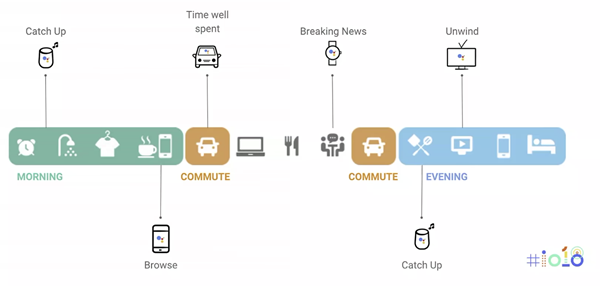

ユーザは多彩なデバイスを使ってAIアシスタントを利用する

(Google I/O 2018より)

「起床から就寝まで」ユーザがAIアシスタントを利用する、という環境整備が進めば進むほど、デバイスが大事なのではなく、AIアシスタントが大事になってくるからです。

マルチモーダルの必要性が増大する

AIアシスタントは様々なデバイスで利用されることが想定されますが、そのデバイスは本当に様々な種別が想定されます。その種別ごとに特徴が異なるため、ユーザがAIアシスタントに対してどのように依頼し、そしてどのようにその結果を得るかは、デバイスによって変わってきます。

AIアシスタントが動作するデバイスの特徴を大きく分類すると、以下が条件となります。

マイクを持ち、音声を聞くことができるか?

スピーカーを持ち、音声を発することができるか?

画面を持ち、何か表示することができるか?

画面を持ち、何か操作することができるか?

具体的なデバイスに上記を当てはめると、以下のようになるでしょう。

デバイス マイク スピーカー 画面 スマートスピーカー ○ ○ × スマートディスプレイ ○ ○ ○ スマートフォン ○ ○ ○ スマートフォン(マナーモード) × × ○

上記のスマートフォンの例のように、同じ一つのデバイスでも、その特徴が状況によって異なることが容易に想像できます。例えば、カーナビは運転中は画面の操作はできませんし、運転者は手と目は運転で利用しているために、口と耳を使って声や音声でのやり取りのみが可能です。しかし、停車中や駐車中については、その限りではありません。カーナビの画面を使って、運転者に様々な情報を伝えることができます。

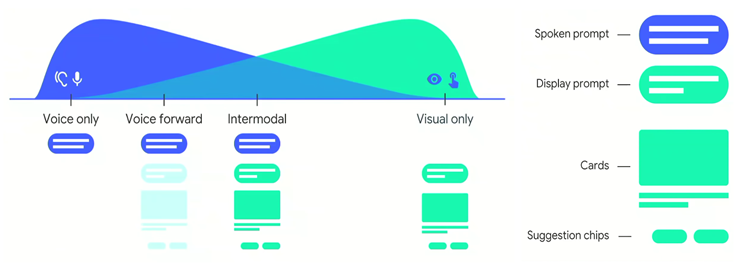

デバイスの特徴に応じて音声と視覚的な表示を最適に選択する

(Google I/O 2018より)

昨年はVUIの登場によって、声のみで何か依頼をして、そして音声で結果を得る、という新しい分野を多くの人々が知ることになりました。しかし、今年から増えるであろう様々なデバイスの形態を通じてユーザがAIアシスタントを使うようになればなるほど、音声のみでは使いづらい状況が増えます。

今年は、AIアシスタントが動作するデバイスの多様化が進むと同時に、AIアシスタント向けのスキル(AlexaやClovaなど)やアクション(Googleアシスタント)の開発者は、デバイスの特徴に応じて最適なレスポンスをどうユーザに返すべきか、模索する年となるでしょう。これは、マルチモーダル対応と呼ばれています。VUIとは、音声のみではなく、視覚的な情報の表現も合わせてVUIと認識されるようになるでしょう。

プライバシー情報の扱いが変化する

デバイスの多様化は、AIアシスタントの利用について利点と欠点の両方を生み出します。例えば、AIアシスタントがユーザのプライバシーに関する情報を扱う際には、気にしなければならない事項が数多く存在します。

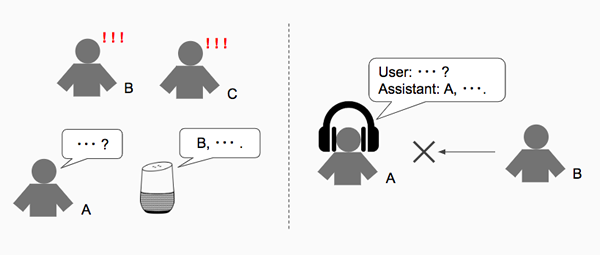

最初に、スマートスピーカーやスマートディスプレイを考えてみましょう。これらのデバイスは、主にリビングやキッチン、寝室など、部屋のどこかに「固定的に」設置されることが前提のデバイスです。そして、一人暮らしではなく家族で住んでいる場合、それらのデバイス経由でAIアシスタントを利用するユーザは、一人ではなく、その家族全員です。

現時点において、音声によるユーザ認証はその精度が残念ながらそう高くはありません。声の質が非常に近い父親と息子あるいは母親と娘といった場合、その声を聞き分けられないこともしばしばです。例えば「今日の予定を教えて」とAIアシスタントに依頼した際に、誰の予定が回答されるかは、音声によるユーザ認証の精度に依存します。つまり、息子が自身の予定を確認しようとしたはずなのに、AIアシスタントが父親の予定を話してしまう、こういった「事故」が容易に発生します。さらに、AIアシスタントに話しかけた本人のみがデバイスの前にいるとは限りません。AIアシスタントからの予期せぬ回答を、予期せぬ人間が聞いてしまう可能性も高いわけです。

この例から、スマートスピーカーやスマートディスプレイなど、部屋に設置して複数人で共用するデバイスについては、AIアシスタントがプライバシー情報を扱うことについては危険性が高い状況であると言えるでしょう。これは、車載デバイスにおいても同じ状況と言えるかもしれません。

次に、スマートフォンやスマートヘッドフォン、スマートウォッチなどを考えてみましょう。これらのデバイスは、手で持ちながら使用する、あるいは身につけて使用する前提のデバイスです。これらのデバイスを同時に使用できる人数は、一人に限られます。複数人で共用することはまれでしょう。

スマートフォンを使って、多くの方々が自身のプライバシー情報を扱っているはずです。それと同じように、それらのデバイスでは、ユーザのプライバシー情報をAIアシスタントが扱えそうです。スマートフォンおよびスマートフォンと連携するウェアラブルデバイスでは、精度の高いユーザ認証が行われている状況です。つまり、それらのデバイス経由でAIアシスタントに話しかけたユーザが誰かを特定することが可能な環境と言えるでしょう。そして、AIアシスタントからの回答も、スマートフォンやウェアラブルデバイスの画面表示やスピーカーからの音声を他人に聞かれる心配は比較的少なく済みます。盗難など第3者の手に渡ってしまったとしても、ロックの機能などにより保護されます。

これらにより、スマートフォンやウェアラブルデバイスでのAIアシスタントの利用については、プライバシー情報を扱うことに対する危険性は比較的小さいと言うことができそうです。

共用するデバイスとウェアラブルデバイスでは、プライバシー情報の扱いが変化する

デバイスの特徴によって、プライバシー情報の取り扱いのレベルが変化することをうまく利用すれば、例えばウェアラブルデバイスにおいてはAIアシスタントがプライバシー情報を扱うことを許可する、といった使い分けができる可能性があります。そして、スキルやアクションの開発者は、ユーザが利用しているデバイスの特徴から、プライバシー情報を取り扱って良い状況かどうかを判断して処理内容を分岐しレスポンスを変化させる、こういった開発が可能になるかもしれません。

今年はAIアシスタントがプライバシー情報をどう取り扱っていくべきなのか、その議論が始まり、そして試行錯誤が行われる年となると予想しています。この議論が進み、うまく整理ができれば、AIアシスタントは多くのユーザにとって、より役に立つ相棒となるに違いありません。

2次的利用に関する環境整備が進む

多くのユーザがAIアシスタントを利用するようになると、AIアシスタントを経由して利用されるスキルやアクションにユーザからの発話内容が蓄積されていきます。ユーザが発言した様々な情報は、そのスキルやアクションの開発者にとって、日々の改善を行っていくための貴重な材料となります。昨年はユーザの発話内容からスキルやアクションの改善点を発見し、さらなる利用につなげていくためにはどのようなことをすれば良いか、その模索が行われた年でした。

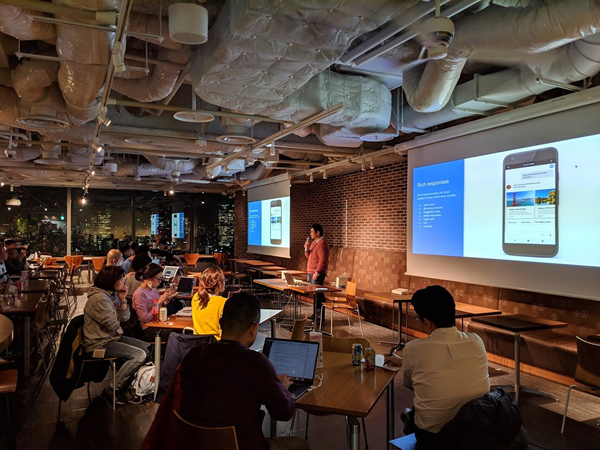

昨年の11月29日に行われたAssistant Developer Conference vol.1 というイベントでは、いくつかのGoogleアシスタント向けアクションの運用と改善に関する工夫について、ディスカッションが行われました。

スキルやアクションの運用をテーマにしたAssistant Developer Conference vol.1

スキルやアクションの改善の材料として蓄積された情報を利用することについては、多くのユーザにとって特に違和感を持つことはないでしょう。しかし、それらの情報が第3者の手に渡ってしまうということを知ったとすると……これは嫌悪感を感じざるを得ないでしょうし、情報管理の上で非常に問題となります。

近年では情報管理の点において法整備も進み、ユーザへの明確な説明と同意により、意図しない情報の2次的利用が行われないようにするための仕組みが整い始めました。利用規約、プライバシーポリシー、ガイドライン、こういった文章を毎日目にすることと思います。これらはユーザおよびユーザの情報を保護し、安全に利用されるようにするために行われている、非常に大事なものとなります。

しかし、それら文章のユーザへの提示は、AIアシスタントおよびスキルやアクションの利用に対してのインタフェースとなるVUIでは、弱点とも言える行為になります。

例えば、画面を持たないスマートスピーカーにて、AIアシスタントにあるスキルやアクションの呼び出しをユーザがお願いしたとします。そのスキルやアクションは、そのユーザに何らかの情報提供を求め、ユーザはそれに回答します。そしてユーザの目的が達成された時点で、会話が終了します。一連の会話内容は、そのスキルやアクションのバックエンドサーバに蓄積されます。その後、実はそのスキルやアクションの開発者は、ユーザとの会話内容を別の業者に提供していました。

この例について、問題点は「会話内容の利用目的をユーザに提示して同意させることなく、スキルやアクションとの会話が行われていること」と言えるでしょう。画面を持つデバイスであれば、利用目的を説明した文章をユーザに提示し、それを読んでもらうことが可能です。しかし、VUIでは「非常に長い利用目的の文章を読み上げ、すべて聞いてもらう」ことが必要になります。聞き終わるまで、ユーザはそのスキルやアクションを利用できず、待たされることになります。これでは誰もそのスキルやアクションを使ってはくれないでしょう。つまり、音声のみでは、ユーザが同意することが可能な現実的なタイミングが見当たらないのです。

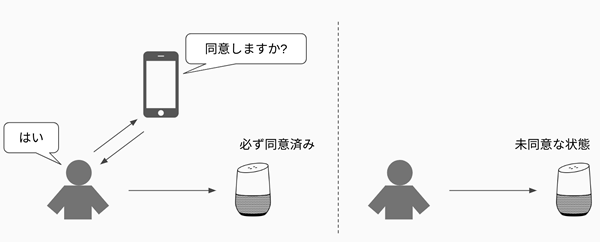

Amazon AlexaやLINE Clovaでは、スキルを利用する際に、そのスキルをスマートフォンアプリ上で有効にする必要がありました(Alexaでは現在有効にしなくてもスキルを呼び出すことが可能です) 。これは、利用規約などの文章の提示と同意が可能な絶好のタイミングであるとも言えます。明示的な同意をしなければスキルを呼び出すことができないため、利用目的についての同意に関する問題はこの形態であればクリアしていることになります。ただし、ユーザの利便性は低いと言えます。

インストール行為による同意と利便性は相反する

今年はユーザとの会話内容の2次的利用について、残念ながら何らかの大きなトラブルが複数件発生するのではないか、と筆者は予想しています。国などにより法律が異なるため、ユーザから提供を受けた情報の取り扱いに対して比較的厳しい法律が存在する場所については、より大きな問題として認識されることになると思います。

現時点では明確な解決方法がありませんが、AIアシスタントの分野におけるこの懸念は必ず乗り越えなければならない壁です。今年は情報の2次的利用についてのディスカッション、そして整備が進む年になるのではないかと考えられます。

通知が本格的に始まる

実は昨年の年始に公開した「2018年のスマートスピーカー 」において、「 通知に関して模索が行われる」と言及しました。昨年の年始の時点で、各AIアシスタントは通知機能を以下のような仕組みですでにサポートしていました。

Googleアシスタント: アクションのバックエンドサーバから送信された通知は、送信相手のユーザが所有するAndroidまたはiOSのスマートフォン向けのPush Notificationとして送信される。通知をタップすることで、そのスマートフォン上でGoogleアシスタントが起動し、通知にて特定されるアクションが呼び出される。 Amazon Alexa: スキルのバックエンドサーバから送信された通知は、送信相手のユーザが所有するAmazon Echoシリーズに送信され、LEDなどの装置を使って通知を受信していることがユーザにアピールされる。ユーザがAlexaに問いかけることで、通知の内容が再生される。 LINE Clova: スキルのバックエンドサーバは、IFTTT経由にて通知を送信することができる。通知はClova WAVEなどのスマートスピーカーに送信され、ランプが点灯することで通知を受信していることがユーザにアピールされる。ユーザがClovaに問いかけることで、通知の内容が再生される。

残念ながら昨年は上記の仕組みを超える新しい通知の仕組みが登場することはありませんでした。依然として、通知の方式は中途半端な状況が続いています。やはり現状では「ユーザからの問いかけに対してAIアシスタントが最大限の価値を提供する」ことが優先されている流れですので、少なくとも今年の前半に通知について何か劇的に進化することは考えにくいと言えるでしょう。

「VUIでの通知」として多くの人々が連想する機能は、やはりAIアシスタントがデバイスを通じてユーザに話しかける、という挙動かと思います。しかし、これを実現しようとすると、以下の懸念が考えられます。

Opt-inとはいえ、スマートスピーカーなどの音声デバイスがいきなり話し出すことに対してユーザが嫌がる可能性

必ずしもユーザにとって価値がある情報が通知されるとは限らない可能性

一度許可してしまったら、数多く無秩序に通知が来るのではないか、とユーザが不安に思う可能性

これらの懸念は、特に複数人で共用することになるスマートスピーカーやスマートディスプレイにて顕著です。

通知に関しても、先ほどのプライバシー情報の取り扱いの話と同じように、ユーザがその時にどんなデバイスを利用しているのか、ユーザの状況はどうなのか、といったコンテキストに依存して、通知の受け方やその際の印象が変わってくると考えられます。

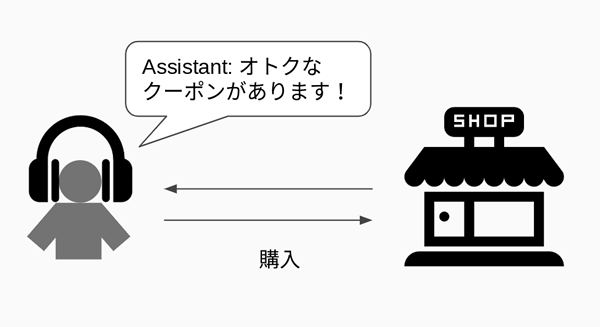

例えば、スマートイヤホンをしながら、ショッピングモールを歩いているとします。あるお店で足を止めた際に、AIアシスタントがそのことを検知して、クーポンやお得情報、新商品についての情報を通知してくれれば、それはユーザにとって価値がある発見となる可能性は高いと思われます。また、テーマパークであれば、乗り物の待ち時間の情報や、ストリートでのパレードやショーに関する案内についても、AIアシスタントから一方的に話されたとしても、それは違和感を感じないはずです。さらに、それらの情報がパーソナライズされていればいるほど、さらに価値は高くなると予想できます。

AIアシスタントからの通知が有効なシチュエーションもある

このように、今年はデバイスの進化やプライバシー情報の取り扱いに関する成果と共に、現状の通知の仕組みが見直され、ユーザにとって最適な情報をもたらしてくれる非常に便利な機能として、通知機能が再登場するものと期待できるでしょう。

企業向けの機能が整備される

現在のスキルやアクションは、AIアシスタント経由でユーザが利用可能になる前に、審査があります。その審査に通過したスキルやアクションは、呼び出しフレーズを使って、多くのユーザが利用できるようになります。ここでのポイントは、「 誰でも利用可能になる」ということです。

ところで、企業内の活動では、多くのコミュニケーションが行われています。情報共有や意思決定、ディスカッションなどが活発に行われています。それらの手段として「会話」が用いられていることは、言うまでもないでしょう。

会話を録音してデジタル化したとするならば、相当な情報量になるはずです。例えば、議事録の書き起こしと要点の抽出を自動化すれば、本来やるべきことにもっと時間を費やせるようになるはずです。こうしたことは、今日の技術で十分に実現可能ですし、それを自ら開発せずとも、クラウドサービスとして提供されている機能の組み合わせで賄うことが可能です。

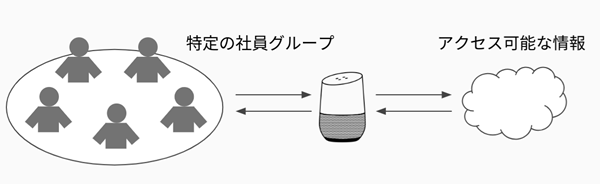

しかし、企業内の情報のほとんどは秘匿情報であり、決して外部に漏れてはなりません。情報の取り扱いは非常に高度な管理が要求されます。各情報に誰がアクセス可能かは厳密に管理される必要があります。

AIアシスタントが管理されたアクセス権を反映することで企業利用が可能になる

この情報へのアクセス権の必要性により、現状のAIアシスタントのプラットフォームでは企業にて利用することは困難です。最も大きな理由は、スキルやアクションの公開範囲を限定する機能がないことです。また、利用範囲を限定するために必要となるユーザ認証の仕組みについても、企業内基幹システムにて多く採用されているLDAPでの組織管理に接続する手段が現状では見当たりません。

今年、デバイスの多様性やプライバシー情報の取り扱いに関して何らかの進歩があれば、企業においてもAIアシスタントの利用が可能となる環境整備が本格的に始まる可能性は十分にあります。そして、例えばスキルやアクションの限定利用については、産業用ロボットの制御を工場内で行うために、あるいは店舗での注文業務での利用など、その適用範囲はかなり広く、一気にAIアシスタントのユーザ形態が多様化することも想定できるでしょう。今年は、スキルやアクションの限定公開機能が登場することを期待します。

検索から問いかけに、読むから聞くに

さて、視点を企業から多くの人々に戻しましょう。

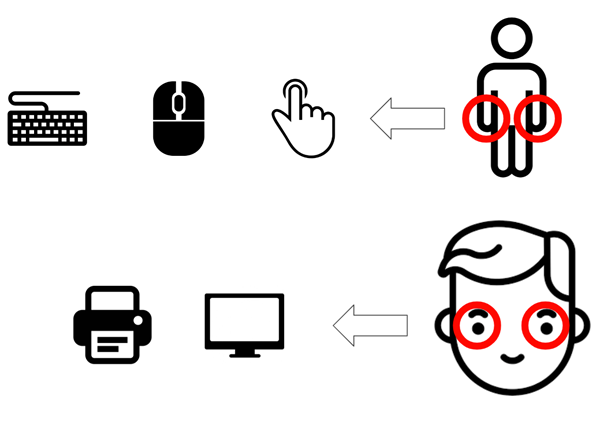

コンピュータをユーザがどのように利用するか、その方法はデバイスの進化とともに変化してきています。大昔は結線を変化させてコンピュータの動作を決定していたワイヤードロジックや、カードに穴を開けてプログラムを読み込ませて処理結果を紙に印字していた時代がありました。もちろん現在ではそのようなことはほとんど行われず、キーボードやマウス、画面のタップ操作などを使って入力を行い、処理結果を画面に表示したり紙に印字したり、といった方法が主流です。

これを言い換えると、手や指で操作し、目で見て処理結果を知る、という使い方と言うことができます。GUI(Graphical User Interface)やCUI(Character User Interface)は、手と目で操作するインタフェースということです。つまり、手や目を別の目的で使用している状況(運転中や料理中など)では、GUIやCUIは利用できません。

GUIやCUIは手と目で操作をするインタフェース

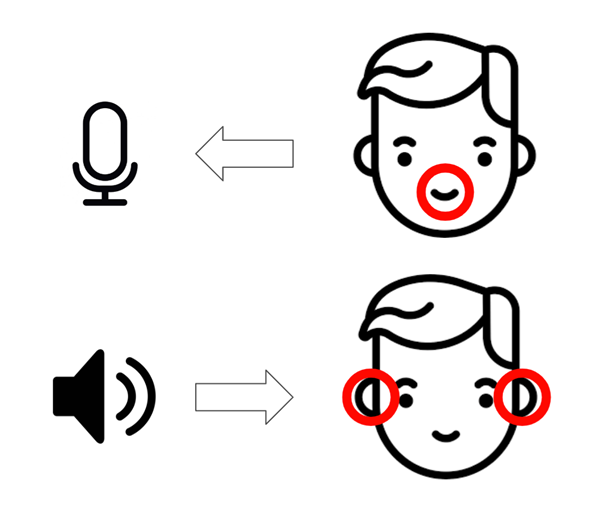

それらに対して、VUIでは基本的に手や目は使いません。その代わりに、VUIでは、口から声を発して操作し、耳で音声を聞いて処理結果を知る、という使い方になります。つまり、VUIは、口と耳を使ってコンピュータを操作するインタフェースと言うことができます。そして、音声を扱うために、マイクやスピーカーといった装置を使用することになります。

VUIは口と耳で操作するインタフェース

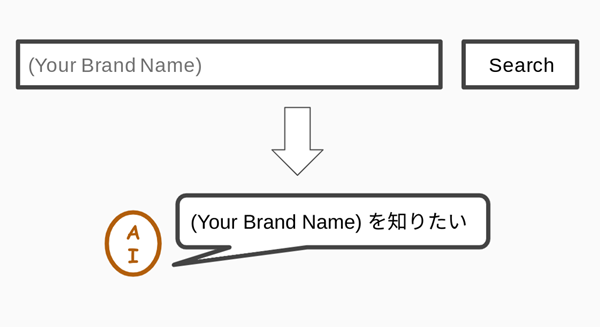

今年はデバイスの多様化と普及によって、AIアシスタントが多くの人々にとって昨年よりも身近な存在になります。その結果、新製品の販促やブランディングなどのための数多くのプロモーションやキャンペーンの手法が変化してくることでしょう。例えば、今まで人々をインターネット上のサイトに誘導したいときには、「 ○○というキーワードで検索してください」という手法が盛んに行われてきました。今年は、「 ○○と話しかけてください」という手法も見かけることになりそうです。

AIアシスタントを利用した手法に変わっていく

また、スマートヘッドフォンやスマートイヤホンといった、常に耳に付けることになるデバイスの利用者が増えることで、多くのユーザが「何かを読む」だけでなく「( AIアシスタントから)何かを聞く」体験が増えてきます。もちろん、音楽はその代表例であって、ヘッドフォンやイヤホンの利用用途のほとんどはそれでしょう。しかし、今年はAIアシスタントからの声を聞くための目的に変化するかもしれません。それは店舗からのお得情報かもしれませんし、「 読書」かもしれません。そして、今年は日本においても、ポッドキャストを発見し聞くために、AIアシスタントの活躍が始まることになりそうです。

また、Googleアシスタントに限定された話ですが、AndroidにApp Actionsが登場することで、Googleアシスタントにより見つけたコンテンツをどのアプリで、そしてどのアクションで利用するかをユーザが選択する、というユースケースが始まります。これにより、如何に自分のアプリやアクションが優先されてユーザにサジェストされるか、という点が非常に重要になってきます。つまり、SEOではなく、AO(Assistant Optimization)という言葉が登場することになるでしょう。そこで大事なことは、小手先のテクニックではなく、如何にユーザにとって価値があるアプリ、アクションであるか、ということになるはずです。

AIアシスタントによって徐々に生活が変わる

昨年はスマートスピーカーを中心としたデバイスの普及と、AIアシスタントを利用する体験を多くの人に伝えてユーザになってもらうための活動が盛んに行われた年でした。しかし、残念ながら「AIアシスタントによって生活が変わった!」と言える人は、そう増えることはなかったかと思います。「 天気を声で聞けるのか、へぇ」といった感想のみで、そのまま利用を終えてしまった方々も多いのではないでしょうか。

AIアシスタント自体には、それほど魅力と言えるものはないのかもしれません。しかし、AIアシスタントは「良き相棒」であり、その相棒ができることが増えれば増えるほど、人々の暮らしはより良くなっていくだろうと期待されています。特に今年以降数年で劇的に生活を変えそうなAIアシスタントのユースケースとして、以下が考えられます。

日々の暮らしで必要となる消耗品を購入するためのインタフェースとして、AIアシスタントに注文を依頼する

ネットワークに接続された家電機器の操作を、AIアシスタントに依頼する

実はこの2点においては、少なくともAlexaおよびGoogleアシスタントにおいては、それぞれのプラットフォームにおいて決済の仕組みおよびIoT機器対応の仕組みの両方ともサポートが完了しています。つまり、あとはそのプラットフォーム上で決済やIoT関連のAPIを使ったスキルやアクションの登場を待つだけの状況が昨年末までに整備されていたのです。

決済機能の利用については、スキルやアクションの開発に関するモチベーションとして非常に重要であり、AIアシスタントのエコシステムの構築を実現するために欠かせない要素です。AlexaではAmazon Payを決済手段として採用した仕組みが、GoogleアシスタントではGoogle Paymentや独自の決済手段を使った仕組みがそれぞれ提供されています。今年は、マネタイズを実現したスキルやアクションが次々と登場するでしょう。そして、多くの人々がそれらに対応したスキルやアクションを使って、より簡単に商品の注文ができるようになり、生活がより楽になっていくことでしょう。

また、昨年後半から、IoTによるインターネットに接続可能な家電製品が次々と販売され始めました。少し前であればSF映画でしか見ることができなかった風景が、現実となってきたのです。また、赤外線リモコンから発せられる信号を記憶して、インターネット経由で信号発信を代わりに行ってくれる機器も数多く販売され、家電を買い換えなくてもAIアシスタント経由で家電操作ができるようにもなりました。特に高齢者にとっては、リモコンの操作についても難しい状況が往々にしてあります。声で家電を操作できることは、今後の高齢者社会に対して、生活レベルを低下させないための手軽な手段として普及すると考えられます。

上記2点だけでも、今年は多くの人々が「AIアシスタントによって生活が変わった!」と実感できる年になるはずです。

まとめ

昨年は「スマートスピーカー元年」と言える年でしたが、今年は「AIアシスタント元年」と言える年になるでしょう。そして、AIアシスタントが人々の生活に深く入り込み、生活がより豊かになったと実感できる年になりそうです。すでにAIアシスタントおよびそれらのプラットフォームの整備はかなり進んでいます。エコシステムが構築されるかどうか、そして人々の生活をAIアシスタントで変えられるかどうか、それは皆さんの手にかかっています。

今年、AIアシスタントは大きく羽ばたきます。この波に乗り遅れることなく、ぜひ自らこのエコシステムに飛び込み、そしてビジネスチャンスを掴んでいただければと思います。