IT専門の人材サービス・アウトソーシング事業を行うパソナテックが6月1日、渋谷のコワーキングスペースLightningspot内にWeb制作やスマホアプリ開発、ソーシャルマーケティング事業を展開する「渋谷Lab(ラボ) 」をオープンしました。本記事では、オープニングイベントとして5夜連続で開催した「shibuya meets tech」イベントの様子を紹介します。

6月4日から8日の5日間にわたって開催されたトークセッション「shibuya meets tech」 。パソナテックによる本イベントは、現場の一線で活躍しているエンジニア、クリエイター7名をゲストに招き、現場に起きている変化を考察しつつ、参加者とディスカッションしながら未来を展望するというもの。6月6日には、デンソーアイティーラボラトリの吉田悠一氏が登場、「 実世界とデータを結ぶ!画像処理技術×スマホのこれから」と題したセッションを行いました。

「AR」と「ユビキタス」

「shibuya meets tech」の3日目となる6月6日は、デンソーアイティーラボラトリの吉田悠一氏によるセッション「実世界とデータを結ぶ!画像処理技術×スマホのこれから」が行われました。吉田氏は同社で画像やインタフェースの研究を行っており、また趣味でもあるiOSのアプリ制作も行い、2ちゃんねるビューアなど合計50万件以上のダウンロードを記録しています。

デンソーアイティーラボラトリの吉田悠一氏

吉田氏はまず、画像認識に関連する用語として「AR」と「ユビキタス」を挙げ、解説を行いました。ARは「Augmented Reality」の意味で、ARそのものは技術を指すものではありません。ARの起源は「Virtual Reality」であり、全周囲型のモニタや立体視、センサ、五感の感触を再現することなどによって仮想空間を実現するというものです。

Mixed Realityとも言われるARは、実世界に映像を投影する手法。その技術的な課題として、ユーザ、対象、場所などの「状況の理解」 、位置合わせなどの「対象の計測」 、投影、シースルー、没入といった「レンダリング方法」を挙げました。また、ARを支える技術として「コンピュータ」 、画像理解のための「コンピュータビジョン」 、画像生成のための「コンピュータグラフィックス」 、カメラやGPS、ジャイロといった「センサ」 、HMD、モニタ、プロジェクタ、スピーカーといった「ディスプレイ」を挙げています。さまざまな課題はありますが、医療や製品開発などの分野を中心に研究が進められています。

セッション会場は満員の熱気に

一方ユビキタスは、Mark Weiser氏が1991年に論文「The computer for the 21st century」で提唱した「Ubiquitous computing」という概念が起源。まさにバズワードとなり、本来の意味は失われていますが、その概念はすでにサービスとして実現されつつあります。本来の概念は「コンピュータは偏在し、常に連携し、人を助ける」というもので、「 自分のコンピュータをどこでも使える」という意味ではありません。

たとえば、近くにあるコンピュータの前に座れば、自分専用のデスクトップが起動する。また、何かを印刷しようとしたときに、自分に一番近いプリンタが自動的に選択される。さらには、共用のモニタの前に立つと自分の予定表が表示されるといったように、自分の周囲にあるコンピュータや周辺機器を、いつでも自分のものとして利用できるという概念といえます。

「AR」と「CA」、有効性の違いは?

続いて吉田氏は、「 CA」について説明しました。CAとは「Context Awareness」の略で、「 人の状況を理解し、助けるコンピューティング」という意味です。たとえば、駅の改札を出ると、その街のお得な情報がプッシュ配信されるといったものです。米国ではショップが採用しているケースも多く、カゴに入れた商品から客の年齢や性別、趣味や嗜好を判断して、おすすめ商品を表示するレコメンデーションに活用されています。Amazonのレコメンデーションや、Webの広告や追跡も同様のものといえるでしょう。

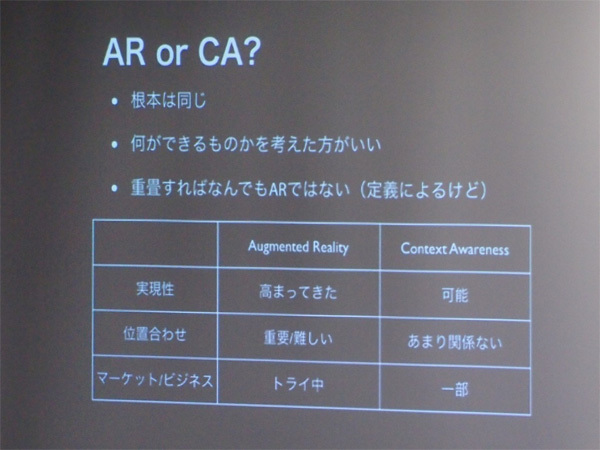

CAにおける技術課題については、GPS、電波、行動履歴、購買履歴といった状況のセンシング、プライバシーをどう定義するか、表示方法をどのようにするのか、また機械学習などによる予測を挙げました。吉田氏はARとCAは根本的に同じもであるとして、どう違うのかということよりも何ができるのかを考えるべきとしています。双方の「実現性」「 位置合わせ」「 マーケット・ビジネス」についても表で説明しました。

ARとCA、それぞれの特徴

ARでもCAでも、さまざまな技術の複合によって実現されています。その中で画像処理が使える領域として、吉田氏は「対象の識別」「 対象の位置姿勢・周囲の形状認識」を挙げました。「 対象の識別」には、2次元コードや画像認識が有効で、対抗技術として「NFC」「 GPS、コンパス、WiFi/基地局による推定」「 GISサーバによる検索」があるとしました。「 対象の位置姿勢・周囲の形状認識」では、2次元コード、トラッキング、3次元計測が有効で、対抗技術として「レーザ、音波による測定」「 Kinnectのようなアクティブセンサ技術」があるとしました。

吉田氏は具体的な例として「セカイカメラ」と「ARカードダス」を挙げ、どのような原理で実現しているかを推測を交えて説明しました。2次元コードの画像からカメラの位置を割り出し、カメラの画像上に仮想物体を描画する際の計算式も示しました。計算そのものは連立方程式のような感覚で解けるといいます。しかし実際には誤差を最小化するための作業が必要になり、ここからが大変としました。

これからは環境の使い分けかがキーに

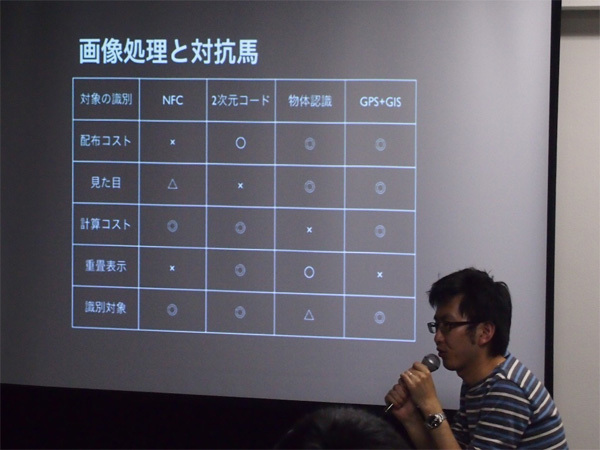

さらに具体例として、metaioによるレゴのARを紹介しました。これはレゴのパッケージをカメラにかざすことで、完成状態が箱の上に表示されるというもの。このケースは画像認識にトラッキングを組み合わせており、多少複雑になっています。画像処理のキーとなるのは「識別・認識対象の多さ」「 位置合わせの正確さ」「 実装・配布の簡単さ」であるとし、NFC、2次元コード、物体認識、GPS+GISの比較表を示しました。

画像処理の技術と向き不向き

それぞれに長所や短所がありますが、なぜ画像にこだわるのか、その理由として、「 人は目で見て判断する」「 カメラが安くなった」「 CPUが速くなった」「 位置合わせがやりやすい・ARと親和性が高い」「 バーコードも使える」といった点を挙げ、何よりも「画像でやったらカッコいい」と吉田氏は強調しました。技術的な面でも、2次元コードの「String」 、コードとトラッキングを用いたPSPのデモ、GPSと画像認識の「Layar」など、組み合わせが無限であることをいいます。

セッションも佳境に入り、吉田氏は「一般物体認識と特定物体認識」について説明しました。現在は「特徴点」ベースによる特定物体認識が基本で、検出する特徴点(キーポイント)の量とそのマッチング技術が進化しているとしました。具体的には、カメラで写した物体についてデータベースから似た画像を探し出す際に、マッチする特徴点の量が多いほど物体の特定が容易になるわけです。デンソーアイティーラボラトリではCARDという高速画像特徴量技術を開発しており、それを使った特定物体認識技術として雑誌の写真をカメラでかざすことで関連する情報を表示するというデモも行いました。

画像認識の技術は多種多様であり、識別なのか、検出なのか、また何が技術の肝なのかによって技術を選ぶことが重要ですが、「 狼を倒す銀の弾丸はない」と吉田氏は言います。最後に画像とモバイルのこれからとして、画像は普通の手段となっていき、処理をサーバで行うかモバイルで行うかという環境の使い分けかがキーになるとしました。アプリケーションの必然性も高くなり、ビジネス化とさらなる技術の進歩が同時に進行していくとして、セッションを締めくくりました。セッションの終了後には懇親会が行われ、吉田氏と参加者が親睦を深めました。

セッションの後は懇親会を開催